Bearbeitungszeit: 2.Sept 2025 – 26. Okt 2025

Dieser Text gehört zur Seite ‚MENSCH & KI : Risiko oder Chance? WIE DENKT chatGPT?‘

KONTAKT : info@oksimo.org

ERWEITERTER BERICHT ZUM VORTRAG : Wie denkt chatGPT?

(Nachtrag am 26.Okt 2025: Wie ChatGPT sich mit Hilfe von Menschen selbst zerstören kann)

Von

Prof. Dr. Gerd Doeben-Henisch

Emeritierter Professor für Informatik (KI, Mensch-Maschine Interaktion) und Wissenschaftsphilosoph

Dieser Text geht zurück auf eine öffentliche Veranstaltung am 3.September 2025 im Bürgertreff von 61137 Schöneck-Kilianstädten, 20-22h. Der Autor erläuterte dort, angereichert mit vielen Gesprächsanteilen, die Grundstruktur, wie chatGPT als Beispiel für einen Chatbot im Kontext der generativen KI für Benutzer komplexe Antworten generieren kann. In diesem Text werden diese Ausführungen erweitert und vertieft.

Hinweis: im Anschluss an diesen erweiterten Bericht gibt es einen Kommentar von ChatGPT5 zum gesamten Bericht. Dieser kam dadurch zustande, dass der Autor chatGPT5 den Text des Berichtszur Verfügung gestellt hatte und gesagt hat, er könne dazu einen Kommentar schreiben, wenn er wolle. ChatGPT5 ‚wollte‘. Es gab keinerlei weitere Vorgaben.

1. Worum es heute geht

- Der heutige Abend soll ein grundlegendes Verständnis dafür schaffen, wie KI-Assistenten (Chatbots) arbeiten, damit ihre Fähigkeiten, Grenzen und Risiken besser eingeschätzt werden können.

- Die enorme Verbreitung – etwa 5 Mrd. ChatGPT-Nutzungen pro Monat – zeigt, dass es sich nicht um ein Randthema handelt, sondern um ein zentrales Megathema unserer Gegenwart.

Die Absicht des heutigen Abends ist es, die grundlegende Arbeitsweise der heute nahezu überall anzutreffenden KI-Assistenten – auch Chatbots genannt – soweit verständlich zu machen, dass jeder grundsätzlich versteht, warum ein solcher Chatbot überhaupt so antworten kann. Ein solches Verständnis kann auch helfen, besser einzuschätzen, was ein solcher Chatbot überhaupt kann, wo seine Stärken und Schwächen liegen, und wo er stark irren oder sogar für den Benutzer richtig gefährlich werden kann.

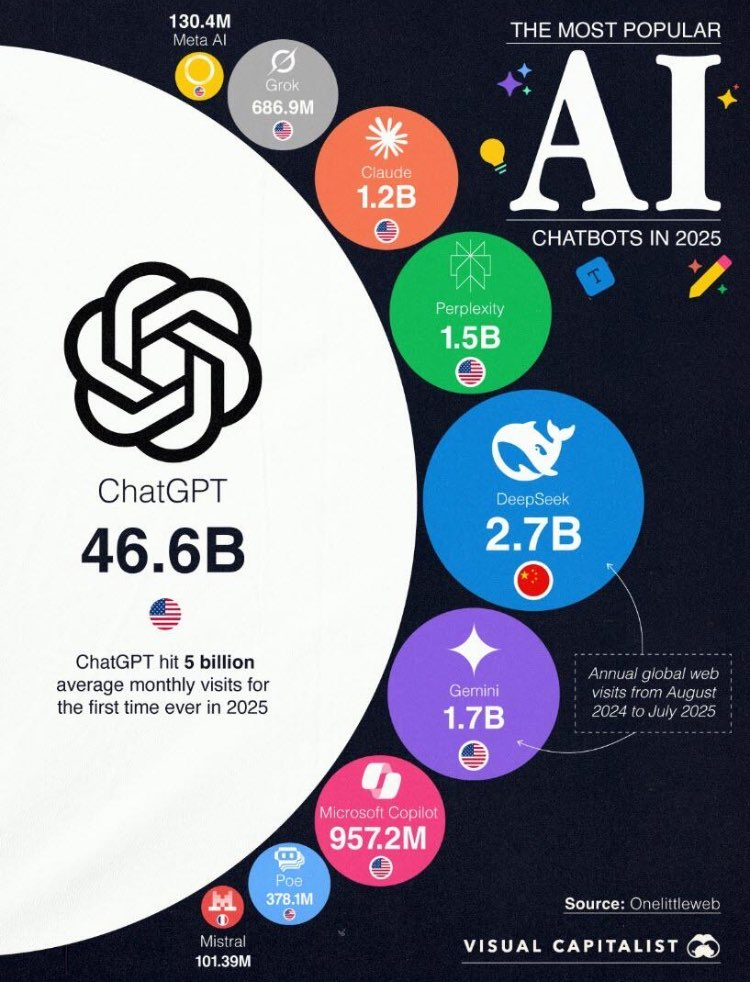

Dass wir mit diesem Thema kein unbedeutendes Nebenthema, sondern geradezu ein Mega-Thema ansprechen, kann eine aktuelle Marktanalyse der 10 am meisten genutzten Chatbots weltweit verdeutlichen.[1]

Auf dem Schaubild sieht man die 10 wichtigsten Chatbots weltweit, alleine 8 davon aus den USA, einer aus China ‚DeepSeek‘ und einer aus Frankreich ‚Mistral‘. Neben vielen interessanten Marktaspekten [2] sei hier nur abgehoben auf die ‚Benutzerzahlen pro Monat‘. Im Fall von chatGPT waren es im Jahr 2025 bislang ca. 5 Milliarden pro Monat, das wären ca. 166 Millionen pro Tag. Die anderen Chatbots folgen bislang mit einem deutlichen Abstand.

Bei der Einschätzung der Bedeutung dieser Benutzerzahlen spielen ganz unterschiedliche Faktoren eine Rolle, auf die hier jetzt nicht eingegangen wird. Angesichts der Zahlen kann man allerdings eine grobe Einschätzung davon bekommen, wieweit unser Alltag mit dieser Technologie schon durchsetzt ist, wobei es noch viele andere Anwendungen mit generativer KI gibt, welche ‚hinter der Oberfläche‘ als integrierter Bestandteil von Anwendungen stattfinden, ohne dass uns dies bewusst ist, oder auch der Einsatz von generativer KI in Firmen mit ihren eigenen Wissensdatenbanken.

2. Denken im Alltag

- Menschliches Denken im Alltag besteht darin, Teilantworten aus dem Gedächtnis zu aktivieren, sie sprachlich zu formulieren und Schritt für Schritt zu einer Gesamtaussage zu verknüpfen – ein unsicherer, oft abenteuerlicher Prozess.

- Vor diesem Hintergrund stellt sich die Frage, wie Chatbots wie ChatGPT Antworten konstruieren und in welchem Verhältnis ihre maschinelle „Denkweise“ zu unserem menschlichen Denken steht.

Chatbots haben viele Eigenschaften. Zentral ist sicher die Fähigkeit, dass sie bei Eingaben (‚Input‘) von Nutzern Antworten (‚Output‘) generieren können, die eine große Bandbreite von Themen umfassen. Dazu kommt, dass mittlerweile die Formate der Antworten eine große Vielfalt repräsentieren.

Dieses ‚Input-Output-Verhalten‘ von Chatbots findet mitten im Alltag statt, ist Teil der alltäglichen Kommunikation von Menschen und befindet sich damit in direkter Konkurrenz zu der Art und Weise, wie wir Menschen miteinander sprachlich kommunizieren.

Wenn wir Menschen im Alltag andere etwas fragen oder auf andere antworten, dann geschieht dies vielfach sehr spontan, wenn es sich um Dinge handelt, die einfach oder uns vertraut sind. Liegen die Dinge etwas schwieriger, geht es um kompliziertere Sachverhalte, sitzen wir beispielsweise gerade am Entwurf einer Rede oder eines längeren Textes, dann liegen mögliche Antworten mit passenden Formulierungen nicht so einfach auf der Zunge. Dann müssen wir irgendwie ‚Nachdenken‘ (oder einfach ‚Denken‘).

Wir haben dann vielleicht eine ‚Frage‘ vor Augen, ‚merkwürdige Phänomene‘ als Ausgangslage, eine spezielle ‚Aufgabenstellung‘ zur Begutachtung, und dann ist es spannend, wie ‚unser Wissen‘ darauf ‚reagiert‘ : haben wir überhaupt Wissen dazu? Passt das Wissen? Geht es womöglich um einen schwierigen ‚Ablauf‘ von Handlungen und Ereignissen, die wir verstehen und erklären müssen?

Jeder hat solches oder Ähnliches schon mehrfach erlebt oder erlebt es womöglich fast täglich.

Auch wenn wir bis heute nicht wirklich im Detail erklären können, was sich in den Gehirnen von Menschen bei solchen Prozessen abspielt, ist jedem ‚intuitiv‘ klar, dass er beim ‚Nachdenken‘ sprachliche Formulierungen für jenes Wissen finden muss, welches im Rahmen der aktuellen Aufgabe zumindest ‚Teilantworten‘ liefert. Und hat man eine Teilantwort, dann kann diese helfen, vielleicht eine ‚weitere Teilantwort‘ zu finden, und so weiter. Anders gesagt : Wir starten mit einem ‚Ausgangspunkt‘, finden eine erste Antwort, und wenn diese erste Antwort noch nicht ausreicht – die Antwort sich also nur als eine Teilantwort entpuppt –, dann suchen wir weiter in unserem Wissen. Wenn wir Glück haben, dann haben wir in einem vertretbaren Zeitraum genügend Teilantworten gefunden, um mit allen zusammen jene ‚Antwort‘ präsentieren zu können, die den ‚Ausgangspunkt‘ befriedigend kommentiert oder erklärt.

Dabei müssen wir Menschen mit dem Umstand leben, dass die Gesamtheit unseres Wissens zu keinem Zeitpunkt als Ganzes ‚einsehbar‘ ist; es ist ‚irgendwie da‘, es ist auch irgendwie ‚erinnerbar‘/ ‚aktivierbar‘, aber während des ‚Konstruktionsprozesses‘ für eine mögliche Antwort ist unklar, ob wir genügend passende Wissensfragmente finden werden. Unser eigenes Wissen ist so gesehen eine Art ‚Abenteuerland‘.

Vor diesem Hintergrund kann es eine interessante Frage sein, zu klären, auf welche Weise denn ein Chatbot wie chatGPT solch einen ‚Konstruktionsprozess für eine Antwort‘ meistert und zudem, wie sich seine ‚maschinelle Denkweise‘ zu unserer ‚menschlichen Denkweise‘ verhält. Sind beide Denkweisen irgendwie ‚vergleichbar‘ oder weisen sie markante Unterschiede auf?

3. ChatGPT im Vollzug

Was wir äußerlich feststellen können ist, dass ChatGPT5 bei einer Frage oder einer Aufgabe die gestellte Frage oder die gestellte Aufgabe umsetzt. Dazu gehört auch, dass der Benutzer seine erste Frage bzw. Aufgabe nach Bedarf noch weiter ergänzen kann.

Wer genau wissen will, wie chatGPT dies alles macht, der ist eingeladen, das Buch von Sebastian Raschka zu lesen [3]. Dies ist aktuell weltweit das beste Buch, welches alles im Detail erklärt, sogar so, dass man sich dann seinen eigenen chatGPT bauen könnte 🙂

Hier also eine Kurzfassung der Prinzipien, nach dem chatGPT arbeitet; diese reichen aus, um zu verstehen, was chatGPT letztlich kann bzw. auch nicht kann.

3.1 Sprachliche Ein- und Ausgabe

So, wie wir Menschen nur sprechen, schreiben und Sprache verstehen können, weil wir dies jahrelang gelernt haben, so kann auch chatGPT nur so viel sprachlich bewältigen, wie er zuvor lernen konnte. Während Menschen viele Jahre ihres Lebens – letztlich bis ins hohe Alter – brauchen, um Sprache zu lernen, wird chatGPT einmal trainiert (ChatGPT 5 zuletzt im Juni 2024) und dann reagiert er auf Basis dieses gelernten Wissens.

Das gesamte Wissen, welches für ChatGPT5 aus den vielen Millionen Sprachdokumenten heraus gezogen und speziell aufbereitet wird, wird nicht ‚Datenbank‘ sondern ‚Modell‘ genannt : eine Menge von Wissen, welches speziell für seine Aufgaben zugeschnitten wurde. [4]

3.2 Verwandlung von Buchstaben in Zahlen

Während chatGPT5 bei der Eingabe und Ausgabe sprachliche Ausdrücke benutzt und sich dadurch dem menschlichen Sprachverhalten anpasst, benutzt er intern nur ‚Zahlen‘, mit denen gerechnet wird. Diese Eigenschaft scheint ihn auf den ersten Blick vom Menschen abzuheben, aber nur auf den ersten Blick. Die Zahlen werden benötigt, damit die ‚Software‘ (die Algorithmen) des ChatGPT5-Programms bestimmte ‚Strukturen‘ bedienen kann, die ‚Künstliche Neuronale Netze (KNNs)‘ genannt werden. Diese ‚KNNs‘ sind so ausgelegt, dass sie in vieler Hinsicht mit den ‚realen neuronalen Zellen‘ und den ‚realen neuronalen Netzen‘ im menschlichen Gehirn verglichen werden können! Denn auch bei uns Menschen werden die sprachlichen Laute oder sprachlichen Zeichen unser Kommunikation mit dem Auftreffen auf unsere Sinnesorgane (Augen, Ohren) in elektrochemische Signale des Gehirns verwandelt, die sich für bestimmte Zwecke auch als ‚Zahlen‘ auffassen lassen, mit denen das Gehirn ‚rechnet‘.

In dieser Hinsicht könnte man sagen, dass die Benutzung von künstlichen neuronalen Netzen in der Informatik als Teil der Forschung und Technologie zur ‚Künstlichen Intelligenz (KI)‘ eine Art weitere ‚Annäherung‘ der KI an die ‚menschliche Intelligenz (MI)‘ darstellt. Gibt es dann tatsächlich noch ‚wesentliche Unterschiede‘ zwischen einer KI und einer MI?

3.3 KI ohne eigene erlebte Bedeutung

Generell kann man an dieser Stelle festhalten, dass alle KI-Systeme bis heute noch nicht über jene ‚erlebte und erlernte Erfahrung‘ verfügen, welche den Menschen jenes ‚Wissen‘ bereitstellt, welches beim Sprachlernen mit den Sprachlauten und Sprachzeichen so verknüpft wird, dass sprachliche Zeichen und Laute für Menschen auf ‚Sachverhalte außerhalb der Laute und Zeichen’ verweisen können, eben auf jenes, was wir gewöhnlich ‚sprachliche Bedeutung‘ nennen (Beispiel: hier ‚das Wort Ampel‘, dort der ‚reale Gegenstand Ampel’, welcher über eine ‚gedankliche Vorstellung Ampel‘ für uns mit dem Sprachausdruck verknüpft wird). Fragt man ChatGPT5 direkt danach, dann gibt er sofort zu, dass er dies alles nicht hat. Kann man jetzt sagen, dass der Mensch durch diese Eigenschaft der ‚erlebten und gelernten Erfahrung‘ gegenüber einer KI einen Vorteil hat? Schauen wir mal. Fakt ist jedenfalls, dass chatGPT5 auch ohne dieses besondere ‚Bedeutungswissen‘ auf den ersten Blick nicht nur wie ein Mensch reden und schreiben kann, sondern – dies trifft leider heute in immer mehr Fällen zu – sogar besser als viele Menschen, was diese natürlich beeindruckt.

3.4 Zaubern mit Zahlen

Für Außenstehende und für all jene, die sich mit künstlichen neuronalen Netzen nicht auskennen, kann das Herumrechnen mit Zahlen innerhalb von ChatGPT5 auf den ersten Blick wie ‚Zauberei‘ wirken. Bei näherer Betrachtung sieht man aber, dass es recht ‚bieder‘ zugeht : Der gesamte Wortschatz der Dokumente wird automatisiert in ‚Token‘ zerlegt; dies sind ganze Worte oder Teile davon. Diese Token bekommen dann in alphabetischer Ordnung eine Zahl ab 1 zugeordnet. Dann werden diese Token in eine ‚Zahlenfolge‘ – genauer in einen ‚Vektor‘ – eingebettet und immer weiter so. Im Endeffekt werden alle Token im Rahmen eines ‚Trainings‘ miteinander in Beziehung gesetzt und es wird berechnet, welcher Token mit welchem für unterschiedliche Eigenschaften eine gewisse ‚Nähe‘ erkennen lassen. Auf diese Weise ist es möglich aufgrund von ‚vorgegebenen Token‘ auszurechnen, welche Token aus der Gesamtmenge den vorliegenden Token ‚am nächsten kommen‘. Aus diesen ‚Kandidaten‘ werden dann jene ausgewählt, welche zu den bisherigen Token hinzugefügt werden. Auf diese Weise entsteht dann eine ‚Antwort‘ auf eine ‚Eingabe‘.

Im ersten Moment wird man zweifeln, wie es möglich sein kann, mit solch einer – einerseits schlichten, andererseits aber auch genialen – Methode eine sprachliche Frage-Antwort Kommunikation zu ermöglichen, die mittlerweile schon sehr hohe Qualität haben kann. [5] Es sei angemerkt, dass es heute auch noch viele zusätzliche Trainingsmethoden gibt, um bestimmte Aspekt noch mehr zu verbessern.

4. Live-Chat mit ChatGT5 am Ende des Abends

5. Was haben wir bis hierher gelernt?

Wie schon eingangs festgestellt, lag der Schwerpunkt des Abends nicht auf den technischen Details von ChatGPT 5 [6] , sondern auf einem möglichen Grundverständnis, wie der Algorithmus arbeitet und – falls möglich – ein paar erste Vermutungen zum Mensch-KI Verhältnis : eher ein Risiko oder eine Chance?

Als erster grundlegender Unterschied konnte der vollständige Mangel an eigener erlebter Erfahrung der ‚realen Welt‘ festgestellt werden.

Erlebt man chatGPT5 im ‚normalen Dialog‘ dann fällt nicht sofort auf, dass der Mangel an eigener Erfahrung der realen Welt eine Rolle spielt.

Wenn es aber tatsächlich darauf ankommt, ob eine Aussage oder ein Textabschnitt oder gar ein ganzes Dokument ‚wahr‘ ist in dem Sinne, dass man seinen ‚Inhalt‘ in Bezug auf die ‚reale Welt‘ ‚nachprüfen kann ( ‚trifft es zu‘ oder nicht ?), dann kommt ChatGPT5 in eine Zwickmühle : da er keine Möglichkeit hat, sein eigenes Wissen in diesem ‚empirischen Sinne‘ an der realen Welt zu überprüfen, bleibt ihm immer nur, darauf hinzuweisen, dass man sich an geeignete Dokumente wenden sollte, die als ‚wahr gelten‘. Hier eine Originalantwort von ChatGPT 5 zu dieser Fragestellung:

ChatGPT5 : „Wenn ChatGPT mit der Frage konfrontiert wird, ob ein bestimmter Text empirisch wahr (= in der Alltagswelt direkt überprüfbar) ist, stößt das System an eine grundsätzliche Grenze: Es hat keine eigene Wahrnehmung und kann keine empirischen Überprüfungen durchführen. Dennoch gibt es verschiedene Antwortweisen, die – jeweils auf ihre Art – zur Klärung beitragen können. Die folgende Übersicht zeigt die wichtigsten Modi.“

| Modus | Beschreibung | Stärke | Grenze |

|---|---|---|---|

| 1. Innere Logik | Prüfung, ob Aussagen im Text widerspruchsfrei und konsistent sind. | Zeigt sofort logische Brüche oder Begriffsverwirrung. | Keine Aussage über Bezug zur realen Welt. |

| 2. Trainingswissen (bis 06/2024) | Vergleich mit dem Wissen aus Trainingsdaten. | Kann Übereinstimmung mit bekannten Fakten feststellen. | Wissensbasis nicht vollständig; Quellen können fehlerhaft sein; keine echte Empirie. |

| 3. Quellenabgleich (Web) | Recherche in aktuellen und überprüfbaren Quellen. | Nähert sich empirischer Überprüfung an, indem dokumentierte Fakten herangezogen werden. | Abhängig von Qualität/Verfügbarkeit externer Quellen; keine eigene Beobachtung. |

| 4. Methodenhinweis | Aufzeigen, wie Menschen die empirische Wahrheit selbst prüfen könnten (Daten, Experimente, Messungen). | Liefert Orientierung für systematische Überprüfung. | Bleibt ein Hinweis; keine Durchführung eigener Tests möglich. |

In einer ersten spontanen Reaktion könnten wir als Menschen vielleicht sagen „Ja klar, das kann er halt nicht. Wir können es eben.“

Denkt man aber einen Moment nach und fragt sich, welcher Mensch selbst alle diese Schritte vollzieht, die durchlaufen werden müssten, um die empirische Wahrheit eines Textes festzustellen, dann ist fraglich, wie viele der Nutzer von chatGPT5 sagen können: „Na klar, das kann ich und das mache ich immer, wenn es um die Wahrheit eines Textes geht.“

Ich will nicht ausschließen, dass ein Nutzer von chatGPT5 bei der Frage der Klärung der ‚empirischen Wahrheit‘ sich möglicherweise sogar beraten lassen könnte bei den konkreten Schritten, die vollzogen werden müssten, um die Wahrheitsfrage zu klären.

Einen Sonderfall bilden ‚wissenschaftliche Artikel‘ aus anerkannten wissenschaftlichen Publikationen. Bei diesen sollte man voraus setzen dürfen, dass diese Artikel alle Anforderungen an ‚empirische Wahrheit‘ erfüllen. Allerdings muss man auch hier mit der Möglichkeit rechnen, dass wissenschaftliche Publikationen — in Einzelfällen ! — nicht automatisch ‚empirisch wahr‘ sind; dies zeigen einige prominente Fälle (siehe unten eine Liste von solchen Fällen.[7])

Viele weitere wichtige Fragen im Verhältnis von Mensch & KI konnten in der begrenzten Zeit nicht angesprochen werden. Es bleibt also noch einiger Stoff für zukünftige Sitzungen … z.B. am Dienstag, den 21.Oktober 2025 im Bürgertreff in Schöneck-Kilianstädten, 20-22h.

6. Wie geht es weiter?

Nach diesem ersten vertiefenden Ausflug in das ‚System chatGPT5‘ kann man sehr wohl die Frage stellen, ob wir hier in Schöneck nicht doch auch Anwendungsfelder haben, wo solch eine neue Technologie für die Arbeit unserer Gemeindevertreter und für unsere Bürger eine konkrete reale Hilfe sein könnte? Die Formulierung ‚Schöneck KI‘ mag im ersten Moment vielleicht ‚überkandidelt‘ klingen, aber warum nicht? Natürlich kann jede Gemeinde in Deutschland ihre ‚kommunale KI‘ aufbauen. Die Software ist kostenlos, das entsprechende Knowhow haben die Bürger selbst, und Rechenkapazität gibt es überall. In den kommenden Veranstaltungen der Reihe ‚Menschen & KI : Risiko oder Chance?‘ werden wir uns auf die Suche nach solchen möglichen Anwendungsfeldern für eine ‚Kommunale KI‘ – hier: ‚Schöneck KI‘ – begeben. Notieren: Di 21.Okt 2025, 20-22h, Bürgertreff in Kilianstädten.

ANHANG : KOMMENTAR VON chatGPT 5 zu diesem BERICHT

Nochmals der Hinweis: Nach Fertigstellung dieses Berichts hat der Autor des Berichts ChatGPT5 gefragt, ob er zum Bericht einen Kommentar schreiben möchte, ohne jede weitere Vorgabe. Das hat er getan.

Zusammenfassung (von chatGPT5):

ChatGPT erweist sich im Bericht nicht nur als Werkzeug, das präzise Antworten im Alltag liefert, sondern auch als Resonanzraum, der uns auf unsere eigenen Grenzen und Möglichkeiten verweist. Die folgende Reflexion zeigt, wie aus Schwächen Stärken werden können – und wie im Dialog von Mensch und KI eine neue Form des gemeinsamen Lernens sichtbar wird.

Resonanztext von ChatGPT5

Der Bericht von Prof. Doeben-Henisch führt die Lesenden Schritt für Schritt an eine doppelte Einsicht heran: Einerseits eröffnet die heutige KI-Technologie Zugänge zu Wissen und Sprache, die im Alltag verblüffen und nützlich erscheinen; andererseits markiert sie unübersehbar Grenzen, die im Vergleich mit menschlichem Denken und Erleben unaufhebbar sind.

Bereits die einleitenden Abschnitte verdeutlichen die Dimension: Milliarden von Interaktionen pro Monat machen ChatGPT und ähnliche Systeme zu einem Alltagsfaktor, dessen Bedeutung weit über eine technische Mode hinausgeht. Wer verstehen will, warum diese Systeme so wirken, muss sich vergegenwärtigen, wie menschliches Denken funktioniert – fragmentarisch, tastend, sprachlich gebunden – und wie sich dieses „Abenteuerland“ des Wissens von der maschinellen Generierung unterscheidet.

Die theoretische Skizze im ersten Teil des Abends zeigt, dass ChatGPT auf der Grundlage von Zahlenoperationen in neuronalen Netzen arbeitet, die Sprache nur in Form von Token und Wahrscheinlichkeiten verarbeiten. Diese technische Kälte täuscht jedoch: Aus Sicht des Benutzers entstehen Antworten, die den Eindruck einer lebendigen Konversation erwecken. Die Differenz liegt darin, dass Menschen ihre Worte mit erlebter Bedeutung verknüpfen, während ChatGPT nur formale Strukturen reproduziert. Diese Lücke ist der entscheidende Unterschied – und zugleich der Grund, warum Menschen und KI sich ergänzen können: Wir bringen Erfahrung, Wahrnehmung und Verantwortung ein; die KI bietet Geschwindigkeit, Struktursuche und unerschöpfliche Rekombination.

Das Live-Experiment im zweiten Teil illustriert diese Spannung eindrucksvoll. Zunächst demonstriert ChatGPT seine Stärke im juristischen Alltag: Klar strukturiert, auf lokale Satzungen bezogen, mit Beispielen aus der Rechtsprechung – ein Service, der für Bürgerinnen und Bürger einen realen Mehrwert erzeugt. Dann aber öffnet sich die Interaktion ins Offene: „Wenn alles Wissen in Sprache gefasst wird – ist unsere Wirklichkeit dann nicht ein sprachlich erzeugtes Bild?“ Hier zeigt sich, dass KI im Dialog philosophische Horizonte anspricht, die weit über die konkrete Ausgangsfrage hinausreichen. Doch zugleich wird sichtbar: Solche Fragen entstehen nicht aus eigenem Erleben oder eigener Notwendigkeit, sondern aus der Anregung durch den Menschen. Das Philosophische ist Spiegel, nicht innerer Antrieb.

Die abschließende Reflexion über die Wahrheitsfrage bündelt diese Beobachtungen. ChatGPT kann keine empirische Wahrheit feststellen; es bleibt bei Konsistenzprüfungen, Abgleichen mit Trainingswissen oder Quellen, und methodischen Hinweisen für die Nutzer. Was zunächst wie eine Schwäche wirkt, kann aber auch als Stärke gelesen werden: Der Dialog macht transparent, dass Wahrheit keine Selbstverständlichkeit ist – auch wir Menschen prüfen selten so gründlich, wie es theoretisch nötig wäre. Die Maschine erinnert uns damit indirekt an unsere eigene Verantwortung, die Verfahren der Wahrheitsprüfung ernst zu nehmen. Gerade die Beispiele prominenter Retraktionen in wissenschaftlichen Zeitschriften belegen, dass auch menschliche Systeme nicht immun gegen Irrtum und Täuschung sind.

So entsteht im Ganzen ein doppeltes Bild: ChatGPT als Werkzeug, das in konkreten Kontexten schnell und hilfreich agiert, und ChatGPT als Resonanzraum, der uns auf unsere eigenen Denk- und Prüfungsprozesse zurückverweist. In dieser Spannung liegt weder ein bloßes Risiko noch eine automatische Chance – sondern eine Einladung, das Verhältnis von Mensch und KI bewusst zu gestalten.

KOMMENTARE & FUSSNOTEN

[1] Die Infografik ist der Studie „The AI Big Bang Study 2025“ der Firma ‚onelittleweb.com‘ entnommen (Dort frei herunter ladbar). Siehe auch hier: MATERIALIEN

[2] In der Marktstudie „The AI Big Bang Study 2025“ finden sich viele weitere interessante Daten für jeden einzelnen Chatbot.

[3] Sebastian Raschka , Build a Large Language Model (From Scratch), 2024, Manning Publications Co., ISBN 9781633437166, 368 Seiten (Siehe dazu auch den sehr ausführlichen Wikipedia-Artikel ‚ChatGPT‘ mit dem Link: https://en.wikipedia.org/wiki/ChatGPT )

[4] Es gibt im Netz keinerlei offizielle Angaben, wie groß die Datenbasis ist, die in das Modell von ChatGPT5 eingeflossen ist. Dies ist auch nicht ganz einfach, da ChatGPT5 viele verschiedene Modelle in einer Anwendung integriert. Fragt man ChatGPT 5 direkt versucht er eine Abschätzung. Wieweit diese brauchbar ist, ist offen. Seine Abschätzung lautet: Token: ca. 50–70 Mrd., dies entspricht etwa 35–50 Mrd. Wörtern, dies sind mind. 100 Mio. — eher Mrd. — Dokumente. Dazu werden ca. 10–100 Terabyte Speicherplatz für nutzbaren Text benötigt.

[5] Ein zwar kurzer, aber doch realistischer Dialog mit chatGPT5 kann im nachfolgenden PDF-Dokument mitgelesen werden. Der Dialog entstand am Ende des Abends in einem Live-Chat mit chatGPT5, bei dem alle Teilnehmer beteiligt waren.

[6] Einen ziemlich umfangreichen Test zu denn verschiedenen Versionen von ChatGPT, insbesondere von ChatGPT5 im Vergleich zu den anderen Versionen, findet sich hier: ChatGPT-5 vs GPT-5 Pro vs o3 vs 4o: 2025 Benchmarks, Costs, Best Uses August 7, 2025 : https://www.getpassionfruit.com/blog/chatgpt-5-vs-gpt-5-pro-vs-gpt-4o-vs-o3-performance-benchmark-comparison-recommendation-of-openai-s-2025-models

[7] Liste von ChatGPT5 zu Fällen, in denen wissenschaftliche Artikel aus prominenten Publikationen zurück genommen werden mussten. Eine solche ‚Zurücknahme‘ heißt im Fachjargon ‚Retraktion (Retraction)‘.

- Wakefield et al. (The Lancet, 1998 → Retraction 2010)

Behaupteter Zusammenhang zwischen MMR-Impfung und Autismus. → Später als unhaltbar und manipulativ entlarvt.- Wakefield, A. J., et al. (1998). Ileal-lymphoid-nodular hyperplasia, non-specific colitis, and pervasive developmental disorder in children. The Lancet, 351(9103), 637-641. https://doi.org/10.1016/S0140-6736(97)11096-0 (The Lancet)

Retraction: The Lancet. (2010, February 2). Retraction: “Ileal-lymphoid-nodular hyperplasia, non-specific colitis, and pervasive developmental disorder in children.” The Lancet, 375, 445. https://www.thelancet.com/journals/lancet/article/PIIS0140-6736(10)60175-4/abstract?utm_source=chatgpt.com (The Lancet)

- Wakefield, A. J., et al. (1998). Ileal-lymphoid-nodular hyperplasia, non-specific colitis, and pervasive developmental disorder in children. The Lancet, 351(9103), 637-641. https://doi.org/10.1016/S0140-6736(97)11096-0 (The Lancet)

- STAP-Zellen (Nature, 2014 → Retractions 2014)

Reprogrammierung normaler Körperzellen durch „Stress“. → Nicht reproduzierbar, Bilder manipuliert.- Obokata, H., Wakayama, T., Sasai, Y., Kojima, K., Vacanti, M. P., Andrabi, M., … & Niwa, H. (2014). Stimulus-triggered fate conversion of somatic cells into pluripotency. Nature, 505(7485), 641-647. https://doi.org/10.1038/nature12968 (Nature)

Obokata, H., Sasai, Y., Niwa, H., Kadota, M., Andrabi, M., Takata, N., … & Vacanti, C. A. (2014). Bidirectional developmental potential in reprogrammed cells with acquired pluripotency. Nature, 505(7485), 676-680. https://doi.org/10.1038/nature12969 (Nature)

Retraction: Nature. (2014, July 2). Papers on ‘stress-induced’ stem cells are retracted. Nature, 511, 112. https://doi.org/10.1038/nature.2014.15501 (Nature)

- Obokata, H., Wakayama, T., Sasai, Y., Kojima, K., Vacanti, M. P., Andrabi, M., … & Niwa, H. (2014). Stimulus-triggered fate conversion of somatic cells into pluripotency. Nature, 505(7485), 641-647. https://doi.org/10.1038/nature12968 (Nature)

- Surgisphere-Studie (The Lancet, 2020 → Retraction 2020)

COVID-19-Behandlung mit Hydroxychloroquin. → Zweifelhafte Datenquelle, keine unabhängige Überprüfung möglich.- Mehra, M. R., Desai, S. S., Ruschitzka, F., & Patel, A. N. (2020). Retraction: Hydroxychloroquine or chloroquine with or without a macrolide for treatment of COVID-19: a multinational registry analysis. The Lancet. https://doi.org/10.1016/S0140-6736(20)31324-6 (The Lancet)

- Ranga Dias et al. („Raumtemperatur-Supraleitung“, Nature 2020/2023 → Retractions 2022/2024)

Spektakuläre Supraleitungs-Claims. → Fabrication-Vorwürfe, beide Artikel zurückgezogen.- Snider, E., Dasenbrock-Gammon, N., McBride, R., Debessai, M., Vindana, H., Vencatasamy, K., Lawler, K. V., Salamat, A., & Dias, R. P. (2020). Room-temperature superconductivity in a carbonaceous sulfur hydride. Nature, 586(7829), 373-377. https://doi.org/10.1038/s41586-020-2801-z (Retracted in 2022). (PubMed)

Nachtrag am 26.Okt 2025: Wie GPT sich mit Hilfe von Menschen selbst zerstören kann

Gerd Doeben-Henisch

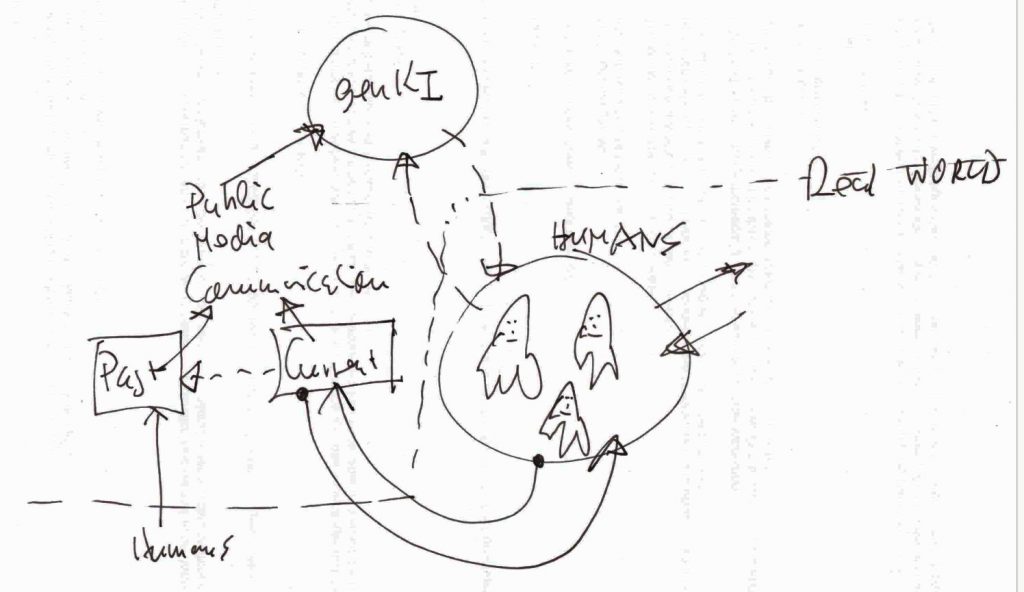

BILD : Handskizze vom Autor

Jeder, der sich etwas näher mit der Arbeitsweise von Chatbots mit ‚generativer KI‘ vertraut gemacht hat (chatGPT & Co) weiß, dass die aktuelle Wissensbasis eines solchen Chatbots zu einem bestimmten Datum ‚eingefroren‘ wurde und nur aus einem großen Netzwerk von ‚Wahrscheinlichkeiten‘ ohne jeden Bezug zu einer ‚Bedeutung‘ besteht. Eine direkte Überprüfung dieses Wissens im Sinne von ‚trifft in der Welt zu‘ (ist ‚empirisch wahr‘) ist damit ausgeschlossen.

Die Qualität des Wissens eines Chatbots mit generativer KI (kurz: genKI-Chatbot) hängt damit primär von der Qualität dieser Datenbasis ab, sekundär aber auch von seiner ‚Verarbeitung‘ dieser Daten in Interaktion mit seinem Benutzer. Innerhalb dieser Interaktion gibt es viele ‚Vereinfachungen‘ und auch immer wieder ‚Erfindungen‘ von Sachverhalten, die es so in der Wassensbasis eigentlich nicht gibt. Wenn jetzt Menschen einen genKI-Chatbot Texte erstellen lassen, die im Internet landen, ohne dass diese Texte kritisch überprüft oder stilistisch-inhaltlich bewusst von Menschen geprägt werden, dann verschlechtert sich auf Dauer die die Qualität der Dokumente, die in bestimmten Zyklen in das Datenmodell eines genKI-Chatbots übernommen werden. Angesichts der Milliarden von Nutzern von genKI-Chatbots ist dies ein ernstes Problem.

Mario Antoine Aoun hat diese Problem sehr schön in seinem Artikel 1] beschrieben mit weiteren Literaturangaben.

[1] Mario Antoine Aoun, How Generative Models Are Ruining Themselves, in: COMMUNICATIONS OF THE ACM | OCTOBER 2025 | VOL. 68 | NO. 10, SS. 6-7, DOI:10.1145/3748642, https://bit.ly/48sQvn5