(11.April 2023 – 16.Mai 2023)

KONTEXT

Dieser Text ist Teil des Lehrprojektes ‚Citizen Science für Nachhaltige Entwicklung‘ im Sommersemester 2023.

GRUNDBEGRIFFE

Mit ‚Grundbegriffen‘ sind hier jene begrifflichen Kontexte gemeint, die für den ‚Verstehenshorizont‘ des Lehrprojekts wichtig sind. In ihnen bündeln sich eine Vielzahl von Annahmen, die ihre Wurzeln in unterschiedlichen Lebens- und Denkbereichen haben.

ZUSAMENFASSUNG

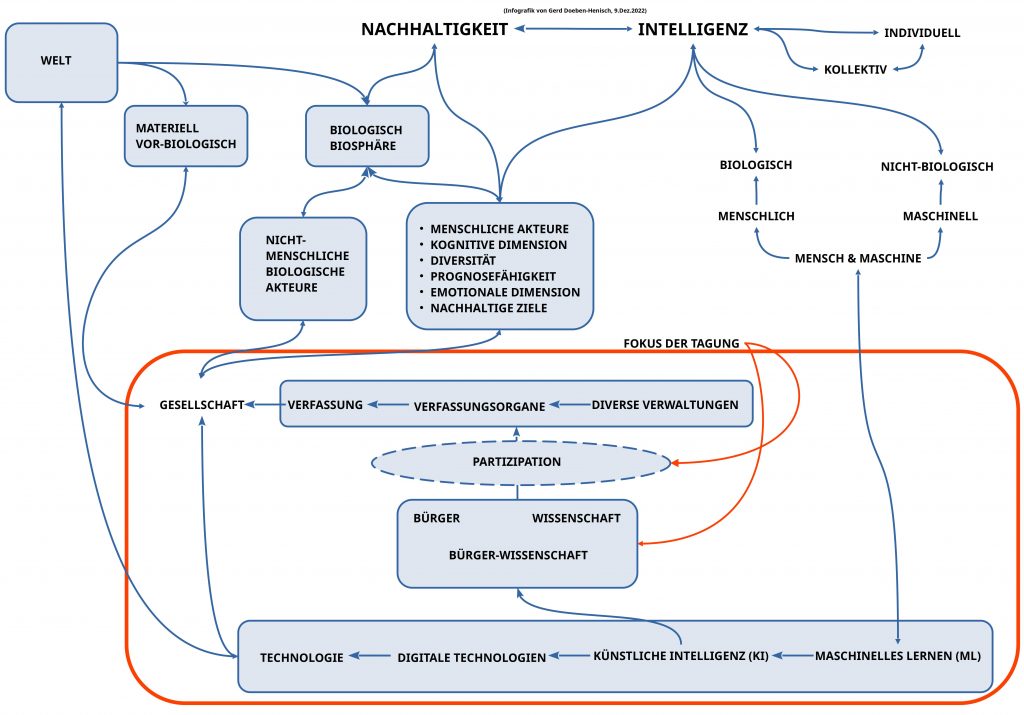

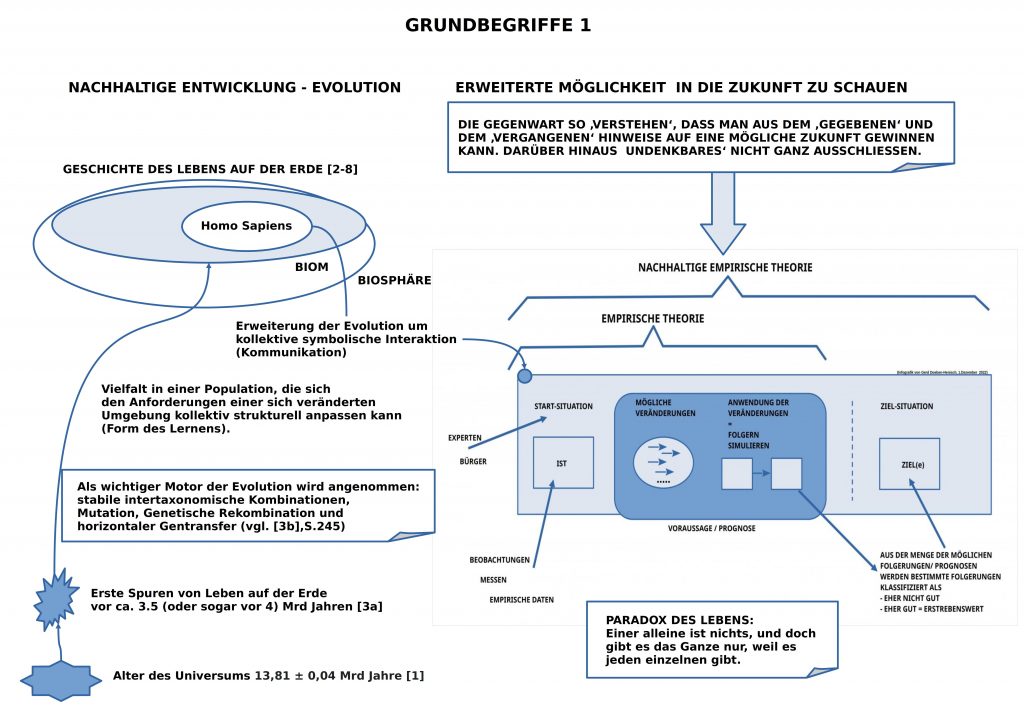

Mit Bezug auf die ‚Biologie‘, hier besonders mit Bezug auf die ‚Entwicklungs-Biologie‘, werden anhand der dynamischen Struktur des Phänomens ‚Leben‘ auf dem Planet Erde jene Eigenschaften hervorgehoben, die sich für ein zukunftsfähiges Leben auf der Erde als wichtig erwiesen haben. Zentral war lange Zeit die Fähigkeit, die biologischen Strukturen materiell so verändern zu können, dass die ‚Passung‘ einer Population zur jeweiligen Umgebung einen für einen ‚Fortbestand hinreichend gut‘ war. Mit dem — evolutionsgeschichtlich — erst ‚kürzlichem‘ Auftreten der Teilpopulation homo sapiens vor ca. 300.000 Jahren wurde eine neue Fähigkeit verfügbar: ’sprachbasierte Kommunikation‘. Diese neue Fähigkeit veränderte das Format der Anpassung an eine mögliche Zukunft radikal. Das Leben auf der Erde konnte sich ansatzweise aus der ‚Gefangenschaft der rein materiellen Strukturänderungen‘ befreien. Mit der Entdeckung des sprachbasierten Konzepts von ‚fiktiver Theorie‘ und dann ‚empirischer Theorie‘ erlangte das Leben auf der Erde über die Teilpopulation homo sapiens die neue Fähigkeit, erfahrungsbasiert komplexe mögliche zukünftige Szenarien des Lebens im Denken und Handeln vorweg zu nehmen. Im Fortschreiten der kulturellen Musterbildungen entstand in den letzten ca. 50 Jahren im Rahmen der Völkergemeinschaft der Vereinten Nationen ein erstes weltweites Bewusstsein über den Sachverhalt globaler Vernetzungen, globaler Entwicklungen, deren Verstehen und Gestaltung das Zusammenwirken aller Menschen weltweit bedarf. Bei aller Globalität benötigt solch ein Zusammenwirken aber auch die ‚konkreten Orte‘, wo jeder einzelne ‚verortet‘ ist: Regionen und Kommunen. Im Konkreten entscheidet sich, was global geschieht, wie auch das Lokale nicht unabhängig vom Globalen ist. Das, was alle Ebenen ansatzweise verknüpfen kann, das ist eine geeignete nachhaltige Theorie. Das Medium, in dem Menschen zusammen all das lernen und ausprobieren können, was die Inhalte einer Theorie ausmacht, ist das ‚Format Spiel‘ in Korrespondenz zur Theorie.

LEBEN ALS GRUND-MODELL NACHHALTIGER ENTWICKLUNG

In den letzten Jahren gewinnt der Begriff ‚Nachhaltig‘ und ‚Nachhaltige Entwicklung‘ innerhalb der Gesellschaft immer mehr Bekanntheit, vielleicht sogar ‚Popularität‘, ja, auch, eine ‚Bedeutung‘ für unser tatsächliches Planen und Handeln.

Was für manche wie eine Art ‚Neuentdeckung‘ wirken mag, gar eine wirkliche ‚Innovation‘ zu sein scheint, ist aber — so lehrt uns die Wissenschaft — eine Eigenschaft, die für das ‚Leben‘ auf diesem Planeten Erde von den frühesten Anfängen an ein ‚Standard‘ war, der wesentlich zum Begriff des Lebens dazu gehört.

Da sich das Phänomen ‚Leben‘ vielen verschiedenen Wissenschaften darbietet und jede Wissenschaft ‚ihr Bild‘ davon zeichnet, ist es schwer, einen gemeinsamen ‚Bedeutungskern‘ zu ermitteln, aber es gibt so eine Art ‚Kernbestand‘, den die meisten akzeptieren (siehe. [4], [5]).

Danach gibt es ‚Leben‘ seit mindestens 3.5 Mrd Jahren auf dem Planet Erde, eher sogar noch früher (vgl. [3a]).

Wie die Biologie mit ihren vielen Teildisziplinen seit mehr als 100 Jahren herausarbeiten konnte [18], unterscheidet man grob zwischen dem ‚Genotyp‘ und dem ‚Phänotyp‘ [17], wobei der Genotyp für einen Pool jener ‚Informationen‘ steht, die bei der Reproduktion einer Zelle wesentlich dafür sind, welches Ergebnis die Hervorbringung einer neuen Zelle in ihrer konkreten Ausprägung (Phänotyp) hat. Aufgrund dieser flexiblen Grundstruktur war das Leben zu allen Zeiten in der Lage, ’sich selbst‘ kontinuierlich zu ‚verändern‘. Die vielen Faktoren, die bei diesem dynamischen Veränderungsprozess mitwirken, bilden ein komplexes Netzwerk von kausalen Beziehungen, das zwar immer besser verstanden wird, aber das bei weitem noch nicht völlig geklärt ist.

Wichtig ist allerdings der Aspekt, dass das sich ‚Reproduzieren‘ und das in einer sich permanent ändernden Umgebung ‚im Spiel halten‘ nicht verstanden werden kann, wenn man nur die einzelnen Exemplare einer Lebensform betrachtet, sondern immer nur das einzelne Exemplar als Teil einer Population, innerhalb der die einzelnen Exemplare auf vielfältige Weise miteinander interagieren! Es trifft hier das harte ‚Paradox‘ zu, das sich mit den Worten umschreiben lässt: „Einer alleine ist nichts, aber das Ganze gibt es nur, weil es jeden einzelnen gibt!“

Diese ‚Interaktionen‘ findet man sowohl auf der Ebene des Genotyps wie auch auf der Ebene des Phänotyps.

Fragt man sich, was denn die zentrale Eigenschaft im Rahmen einer Reproduktion ist, die für das Ganze der Population den entscheidenden Faktor für eine nachhaltige Entwicklung bildet, dann wird man ins Leere laufen, solange man nicht die ‚übergreifende Funktionalität‘ versteht, die in dem Gesamtprozess ‚eingebettet‘ ist und die ein Lebewesen dazu befähigt, die ‚Bedeutungslosigkeit einer Gegenwart‘ in eine ‚potentiell bedeutungsvolle Zukunft‘ zu verwandeln.

FUNDAMENTAL: DIE ÜBERWINDUNG DER GEGENWART

Dazu ist es wichtig, dass man sich klar macht, dass ‚Zukunft‘ kein ‚Objekt‘ ist, das irgendwie konkret in einer jeweiligen Umgebung vorkommt. Es kann zwar — vielleicht — irgendwann eine konkrete Situation geben, die für ein Lebewesen etwas repräsentiert, was in seiner Struktur und in seinen Prozessen ‚potentiell vorhanden war‘, aber dieses ‚potentiell Vorhandensein‘ ist kein reales Objekt, sondern dieses sind ‚bestimmte interne Zustände‘ des Lebewesens, die geeignet sind, dass ein Lebewesen durch sie sein Verhalten so steuern kann, dass es mit dazu beiträgt, dass irgendwann in der realen Umgebung eine Umgebungssituation entsteht, die dann als ‚Realisierung jener internen Zustände‘ gesehen werden kann, die eine ‚potentielle Situation‘ repräsentiert haben.

Im einfachsten Fall sind diese ‚internen Zustände‘ molekulare Eigenschaften des genetischen Informationspools, die sich ergeben haben, und deren ‚Übersetzung‘ in ‚Prozesse‘ und neue ‚Zellstrukturen‘ zu einem individuellen Lebewesen führen, das so vorher noch nicht da war. Einige ’neue Verhaltensweisen‘ werden dadurch evtl. möglich und diese sind — im positiven Fall — dafür geeignet, dass das Lebewesen in der jeweiligen Umgebung ‚überlebt‘ oder gar ‚besser‘ leben kann.

In der Regel nützen solche ’neue Eigenschaften‘ aber nur dann etwas, wenn das jeweilige Lebewesen zusammen mit den Artgenossen in der aktuellen Umgebung ‚gemeinsam besser‘ leben kann.

Diese internen Eigenschaften, die potentiell neue Strukturen repräsentieren, bilden die ‚Gegenwart‘ nicht 1-zu-1 ab, sondern sie ‚repräsentieren‘ die jeweilige Gegenwart in bestimmten Eigenschaften auf meist recht allgemeine Art. Und sie bilden nicht ‚die‘ Gegenwart ab, sondern ‚ganz viele verschiedene Gegenwarten‘, die ‚aufeinander folgen‘ und die sich als ‚veränderlich‘ zeigen. So kann aus einem Repräsentanten einer Gegenwart G1 der Repräsentant einer Vergangenheit V1 werden, und in der Menge der verschiedenen Repräsentanten können ‚Beziehungen sichtbar‘ werden, die in einer ‚Vorher-Nachher‘ Beziehung ‚Veränderungen‘ aufleuchten lassen können.

Wieweit sich im molekularen Detail der genetischen Informationsstrukturen zeitliche Veränderungsbeziehungen tatsächlich auswirken und wie genau, das dürfte aktuell in der Forschung noch nicht völlig geklärt sein. Klar ist nur, dass die Dynamik des molekularen Repräsentations- und Kombinationssystems das Potential besitzt, eine gegenwärtige Struktur durch Veränderung in eine ’neue‘ Struktur zu überführen.

ZUKUNFTS-VERSTÄRKER SPRACHE

Während sich die einfachen Lebensformen ihre mögliche ’neue Zukunft‘ nur durch Strukturveränderungen im Bereich ihrer molekularen Strukturen erkämpfen können (was vielfältige Formen von Interaktionen zwischen den internen molekularen Strukturen und sie umgebende Prozesse mit einschließt), können komplexe Lebensformen — am intensivsten bislang der Homo sapiens (wir Menschen) — durch das System einer ‚Sprache‘ sowohl die ‚Ausdrucksstärke‘ ‚potentieller Strukturen‘ gewaltig vergrößern, wie aber auch die ‚Geschwindigkeit ihrer Erzeugung‘.

Die Sprache ist ein recht junges ‚Subsystem des Gehirns‘ [3c], das es einem Lebewesen ermöglicht, eine Reihe von ‚internen Zuständen‘, die normalerweise einem anderen Lebewesen nicht direkt zugänglich sind, durch Zwischenschaltung des Systems Sprache in solche Elemente ‚abbilden‘ zu können, die äußerlich wahrnehmbar sind (Laute, Zeichen, Gesten, …). Und da alle Mitglieder einer Lebensform, die über das Subsystem Sprache verfügbar, über das gleiche Subsystem verfügen, können Lebewesen mit dem Subsystem Sprache sich nicht nur über das vorliegen eines internen Zustands ‚austauschen‘ (‚Kommunikation‘), sie können sich darüber hinaus aufgrund solcher sprachlicher Austauschprozesse auch begrenzt ‚koordinieren‘. Dies ermöglicht einen radikalen Evolutionsschub, wie wir ihn in der Geschichte des Lebens seit dem Auftreten des Homo sapiens beobachten können.({2],S.454f, [3c])

Durch diese ‚Sichtbarmachung‘ interner Zustände eines Lebewesens für Kommunikation und Koordination ergaben sich bahnbrechende Entwicklungen wie die Erfindung der ‚Schrift‘, des ‚Buches‘, der ‚Bibliothek‘ oder dann die weitere Erfindung ‚digitaler Medien‘, wodurch nicht nur die ‚Speicherung‘ und die ‚Vervielfältigung‘ von sprachlichem Ausdruck einen gewaltigen Schub bekam, sondern mit ‚digitalen Maschinen‘ wurden auch neue Formen der ‚automatisierten Bearbeitung‘ von Sprache möglich. Allerdings geht mit der ‚digitalen Revolution‘ eine zunehmende ‚Verwirrung‘ einher, da die neuen digitalen Technologien die ‚Wurzel der Sprache‘, ihre ‚Schnittstellenfunktion‘ zwischen ‚Innerem‘ und ‚Äußerem‘ immer mehr aus dem Blick gerät. Dies kann zu einer Art ‚Entfremdung des Menschen von sich selbst‘ führen, was dann kontraproduktiv wäre.

ZUKUNFTS-VERSTÄRKER THEORIE

Die Sprache ermöglicht die Bildung ganz neuartiger Strukturen in alle Richtungen. Allerdings weiß jeder, dass nicht jeder Gedanke automatisch ‚brauchbar‘ ist für die Beschreibung einer ‚möglichen Konstellation‘ für einen zukünftigen Zeitpunkt. Auf der einen Seite ist die Menge möglicher Zustände in einer möglichen Zukunft zwar generell viel größer als alles, was wir mit dem Wissen einer bestimmten Zeit bewusst ‚denken‘ können, aber die Menschheit hat in den letzten 500 Jahren schrittweise gelernt, dass es eine Reihe von Phänomenen in dieser Welt gibt, denen eine gewisse ‚Regelhaftigkeit‘ zukommt. Und wenn man diese Regelhaftigkeit ‚entdecken‘ kann, dann kann man diese Beobachtungen in Form von ‚Veränderungs-Regeln‘ mittels Sprache festhalten und sie bis zu einem gewissen Grad als ‚Handlungsanleitungen‘ benutzen. Dieses ‚Beobachten‘ der Welt mit Blick auf ‚Regelhaftigkeiten‘ und deren Nutzung für ‚Voraussagen‘ wahrscheinlicher zukünftiger Zustände hat sich zu einem ‚kulturellen Muster‘ verdichtet, das wir ‚Empirische Wissenschaft‘ nennen.

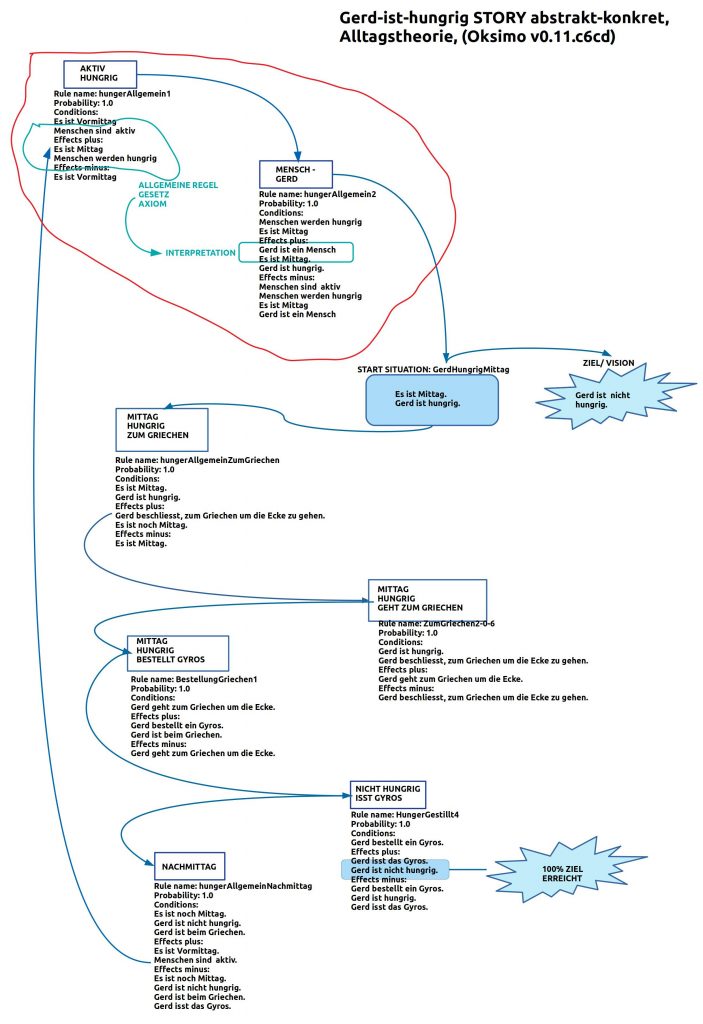

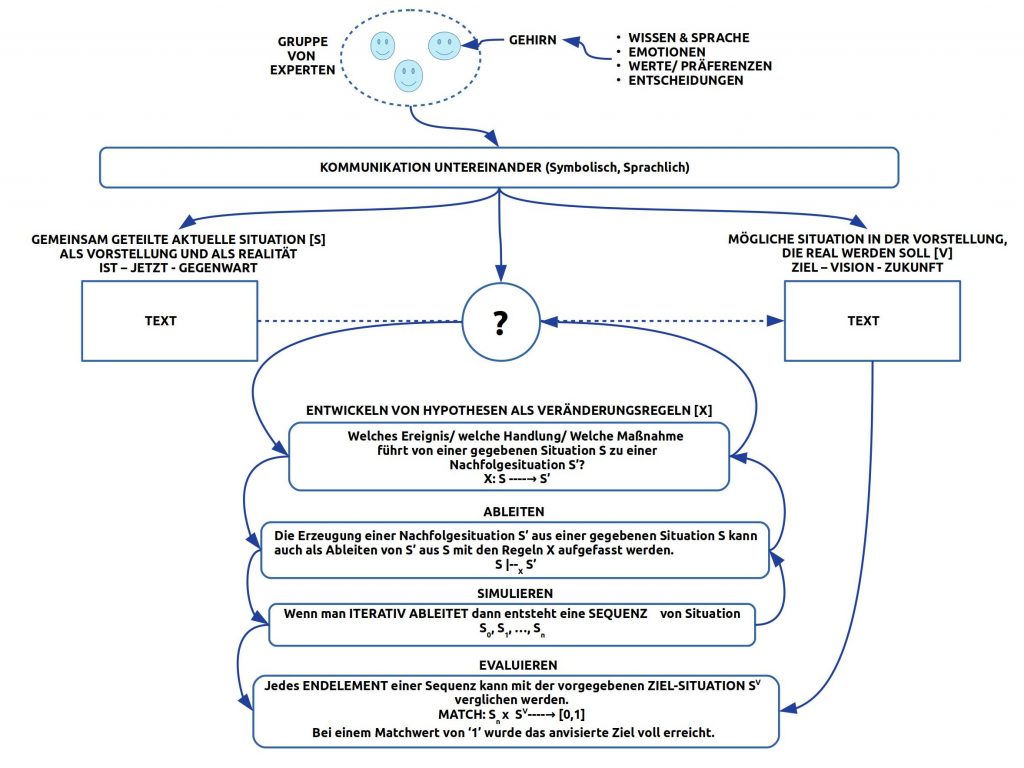

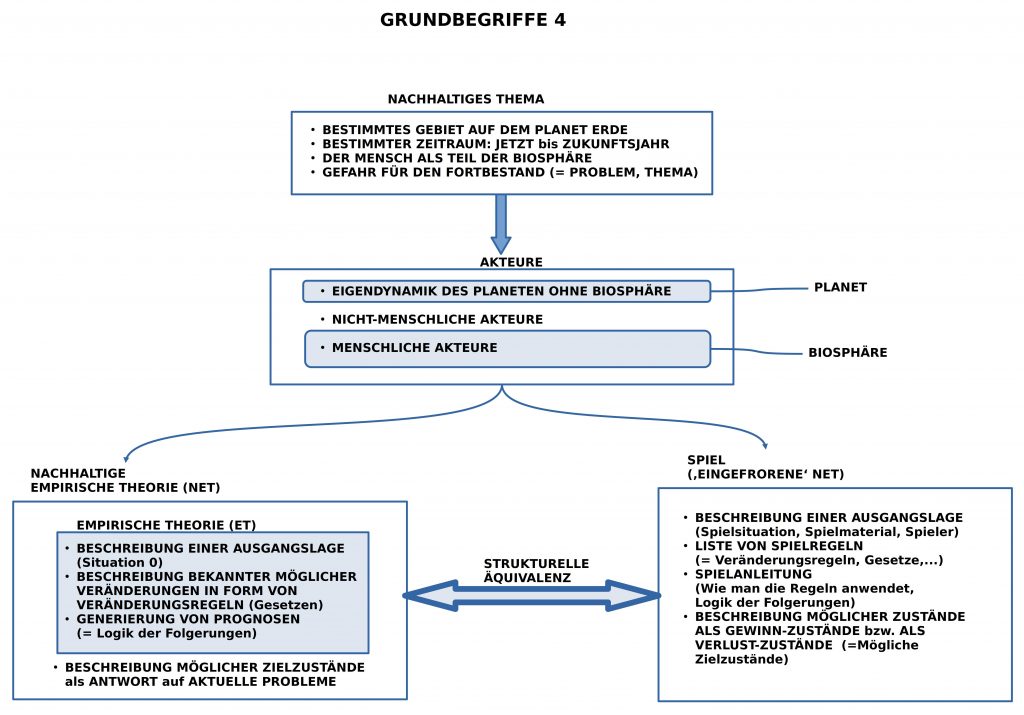

Das vorausgehende Schaubild macht die Kernelemente einer empirischen Theorie deutlich:

- Man muss sich auf eine ‚Ausgangssituation‘ einigen, die man gemeinsam so beschreibt, dass alle zustimmen können, dass der Text einer tatsächlichen Situation entspricht.

- Man braucht eine Menge von Veränderungs-Regeln, die beschreiben, wie bei einer bestimmten Menge von Eigenschaften, die vorliegen, diese sich so verändern können, dass bestimmte Eigenschaften ’neu‘ dazu kommen und andere — möglicherweise — verschwinden.

- Man braucht dann eine ‚Vereinbarung‘, wie man Veränderungs-Regeln so ‚anwendet‘, dass genau dieser erhoffte Effekt eintritt (Logiker sprechen hier von einem ‚Folgerungsbegriff‘).

- Der neue Zustand, der durch Anwendung von Veränderungs-Regeln neu entsteht, wird dann zum neuen Ausgangspunkt für eine mögliche weitere Anwendung von Veränderungs-Regeln.

- Auf diese Weise kann eine ganze ‚Folge‘ (‚Serie’/ ‚Reihe‘ …) von Zuständen zustande kommen, die zusammen einen ‚Prozess‘ repräsentieren, der — im idealen Fall – zu einem neuen Zustand führt, der nach bestimmten Kriterien als ‚besser‘ gewertet wird als der Ausgangszustand; im negativen Fall tritt der ‚erwartete neue Zustand‘ ’nicht ein‘.

An dieser Stelle ist wichtig, den Unterschied zwischen einer ‚Empirischen Theorie (ET)‘ und einer ‚Nachhaltigen Empirischen Theorie (NET)‘ zu verdeutlichen. Eine empirische Theorie umfasst eigentlich ’nur‘ Veränderungs-Regeln, die das Erzeugen eines bestimmten Nachfolge-Zustands erlauben. Ob dieser Zustand ‚gut‘ oder ’nicht gut‘ ist ist nicht Gegenstand einer empirischen Theorie. In der Alltagswelt der Menschen braucht man aber Anhaltspunkte, ob ein bestimmter Zustand nun ‚eher besser‘ oder ‚eher schlechter‘ ist, da man ansonsten nicht weiß, in welche Richtung man sich weiter engagieren sollte.

Um solche ‚Bewertungen‘ wie ‚eher besser‘ oder ‚eher schlechter‘ vornehmen zu können, benötigt man ‚Präferenz-Regeln‘ durch die eine Gesellschaft sich festlegt, was sie ‚besser‘ oder ’schlechter‘ findet.

Kombiniert man eine empirische Theorie mit solchen Präferenz-Regeln, dann kann man eine empirische Theorie (ET) in eine nachhaltige empirische Theorie (NET) verwandeln. Man kombiniert dann das empirische ‚Veränderungswissen‘ mit einem normativen ‚Präferenz-Wissen‘ so, dass man jederzeit entscheiden kann, ob ein Prozess in einem ‚erstrebenswerten‘ Zustand geendet hat oder nicht.

An diesem Beispiel kann man auch sehen, dass Wissen ‚kein Selbstzweck‘ ist sondern ein Instrument ist, um die Menschen zu unterstützen, eher jene Zustände zu finden, die ‚erstrebenswert‘ sind oder eben nicht.

NACHHALTIGE ENTWICKLUNG UND MENSCHLICHE ZIVILISATION – DIE STIMME DER VEREINTEN NATIONEN

Wie schon eingangs erwähnt ist das Leben auf diesem Planeten schon immer grundsätzlich ’nachhaltig‘, so sehr, dass es mehr als 3.5 Mrd Jahre in der Lage war, die teilweise dramatischen Änderungen der Verhältnisse auf dem Planet Erde zu überstehen.

Wir Menschen als Lebensform ‚Homo sapiens‘ haben einerseits von dieser Überlebensform profitiert, andererseits verfügt die Lebensform ‚Homo sapiens‘ über einige dramatisch neue und leistungsfähige Eigenschaften, die ihn in die Lage versetzen, anders, schneller und radikaler die Verhältnis auf dem Planeten Erde zu verändern, so, dass sich die Anzeichen verdichten, dass der Mensch die Grundlagen des gesamten Lebens, insbesondere seines eigenen Lebens, schrittweise irreparabel zerstört.

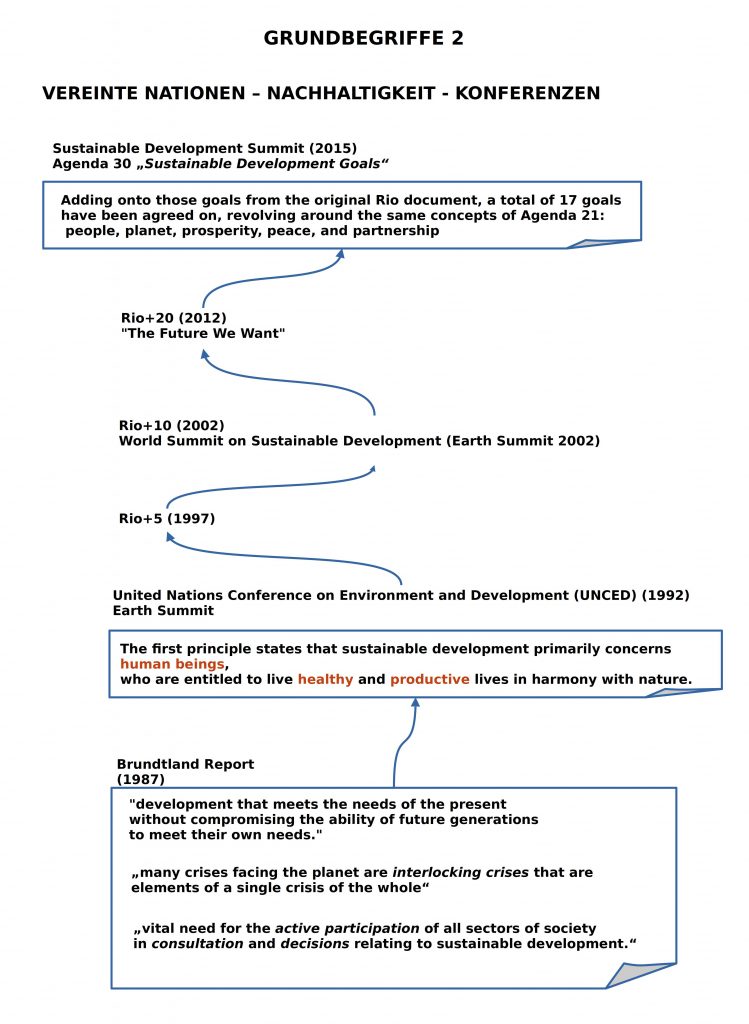

Allerdings, man muss nüchtern sehen, dass die Lebensform Homo sapiens überhaupt ‚lernen‘ musste, wie sie ist, was sie kann, und wie sie mit dem übrigen Leben eigentlich zusammenhängt. Grob gesprochen kann man sagen, dass der Homo sapiens ca. 300.000 Jahre gebraucht hat, um jetzt ansatzweise zu verstehen, wer er ist, was er tut, und welche unfassbaren Wirkungen er erzeugt hat und permanent erzeugt. Vor diesem Hintergrund kann man die Geschichte der Vereinten Nationen mit ihren Konferenzen zur Nachhaltigkeit verstehen als ein langsames ‚kulturelles Bewusst werden‘ seiner selbst und seiner Wechselwirkung mit der Umwelt, mit dem Planeten Erde.

Die Einschätzung der Texte der Konferenzen — hier beginnend mit dem sogenannten Brundtland Reporrt von 1987 [9] — variiert stark. Diese Texte bilden auch keine ‚Theorie‘ im klassischen Sinne, sie sind nicht unbedingt einheitlich, nicht konsistent, aber man kann sich bei ihrer Lektüre nicht des Eindrucks entziehen, dass hier Menschen, Völker, Nationen darum ringen, wie man die Lage einzuschätzen hat und was zu tun ist. Dabei wird auch ganz deutlich, dass hier nicht alle Beteiligten nur darauf warten, los zu legen oder genau das zu tun, wovon die Dokumente sprechen. Zu unterschiedlich sind die Ausgangslagen der verschiedenen Nationen, Völker, Kulturen, Menschen.

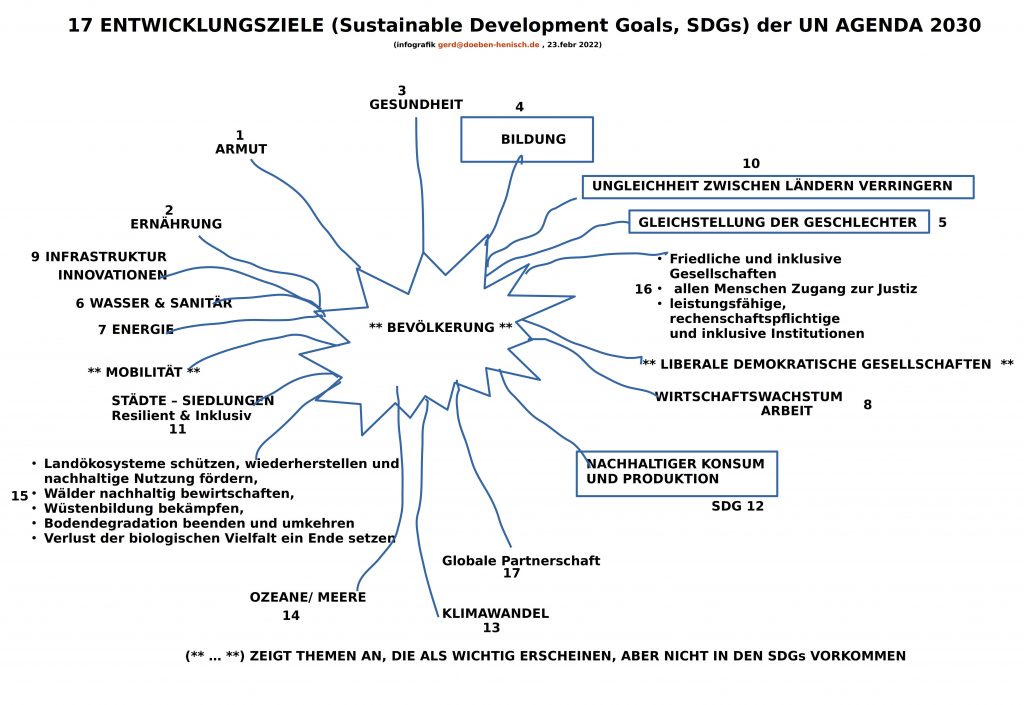

Der Autor dieses Textes versteht den sogenannten Brundtland-Report als den aufschlussreichsten Text für das Gesamtprojekt. Die sehr populären ’17 Entwicklungsziele‘ [10,11] wirken zwar vielfältig, aber man tut sich schwer in ihnen eine klare Linie, ein klares Gesamtkonzept zu erkennen.

17 TEILZIELE NACHHALTIGER ENTWICKLUNG. ES GIBT MEHR …

Zudem kann man unschwer erkennen, dass viele andere Ziele, die eigentlich wichtig sind, unter diesen 17 Entwicklungs-Zielen nicht vorkommen. Ganz zentral z.B. das Thema ‚Bevölkerung‘: alle anderen Ziele hängen von der Größe Bevölkerung ab; allein die Beschaffenheit der Bevölkerungsstrukturen kann darüber entscheiden, ob ganze Regionen oder gar Kontinente in unlebbaren Zuständen versinken. Diesen zentralen Begriff nicht gemeinsam zu reflektieren und entsprechende Modelle zu erarbeiten, entzieht fast allen anderen Begriffen die konkrete Grundlage!

ZIELE BRAUCHEN EINEN ORT UND AKTEURE: DIE KOMMUNE

Das Reden von ‚Zielen‘ und deren ‚Einlösung‘ verlangt nach ‚Akteuren‘, die sich um die Einlösung der Ziele kümmern. Wo findet man diese Akteure?

Letztlich sind es wir alle, und wir alle haben irgendwo auf diesem Planeten einen Ort (bisweilen auch mehrere), wo wir ‚im Alltag‘ leben. Diese alltäglichen Orte sind die Kommunen, die Dörfer und Städte.

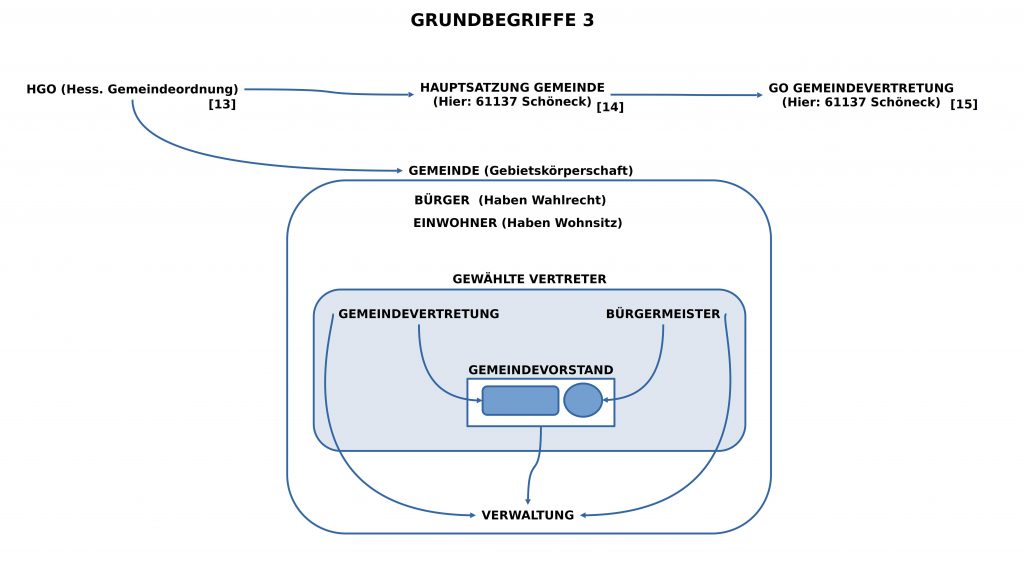

In einem Deutschen Bundesland — hier Hessen — gibt es als ‚Menge von Spielregeln‘ für die Organisation einer Gemeinde die ‚Gemeindeordnung (HGO)‘ [13], die dann durch zahlreiche andere Verordnungen noch ergänzt wird bzw. ergänzt werden kann (z.B. die ‚Hauptsatzung‘ [14] oder die ‚Geschäftsordnung‘ für die gewählte ‚Gemeindevertretung‘ [15]).

Die Basis jeder Gemeinde (Kommune) sind die ‚Einwohner‘, jene Menschen, die in der Gemeinde eine Wohnung haben, bzw. die ‚Bürger‘, das sind jene Einwohner, die auch ‚wählen‘ dürfen.

In regelmäßigen Wahlen wird eine bestimmte Anzahl von ‚Gemeindevertretern‘ gewählt, die die ‚Gemeindevertretung‘ bilden, und parallel wird separat der ‚Bürgermeister‘ gewählt. Mitglieder der Gemeindevertretung und der Bürgermeister bilden zusammen den ‚Gemeindevorstand‘. Wahlunabhängig gibt es die ‚Gemeindeverwaltung‘, die von allen drei Gremien auf unterschiedliche Weise bestimmt oder geleitet wird.

Die ‚Schnittstellen‘ zwischen Einwohnern und den politisch gewählten Vertretungen (samt Verwaltung) sind sehr vielfältig.

Ein ungelöstes Problem ist heute die Herausforderung, dass die Welt nicht nur ’schneller‘, sondern auch ‚komplexer‘ geworden ist und dass die zahlenmäßig kleine Gruppe der gewählten Gemeindevertreter mit ihren Kompetenzen alleine kaum in der Lage sind, die täglichen Aufgaben umfassend gut bewältigen zu können, speziell dann nicht, wenn diese Aufgaben — was nicht selten ist — für ihre Umsetzung 10 und mehr Jahre benötigen.

Auf der anderen Seite repräsentiert die Menge aller Einwohner ein großes Reservoir an Erfahrung und Wissen. Allein durch aktives Wählen wird dieser Schatz an Erfahrung und Wissen nicht angemessen genutzt. Es fragt sich, wie ein neues konstruktives Verhältnis zwischen Bürgern und ihren gewählten Vertretern aussehen könnte?

GEGENWART ÜBERWINDEN durch ‚THEORIE‘ und ‚SPIEL‘

Nach all diesen Vorüberlegungen stellt sich die praktische Frage, was denn eine Gruppe von Bürgern — eventuell zusammen mit gewählten politischen Vertretern — konkret tun könnte, um in ihrer Kommune konkrete Zukunftsarbeit zu leisten.

Wenn diese Arbeit auf eine Entwicklung abzielt, die wirklich nachhaltig sein soll, tatsächlich wichtige mögliche Zustände einer möglichen Zukunft adressieren möchte, dann gilt nach den bisherigen Vorüberlegungen, dass die Vorgehensweise dieser Bürger die ‚Form einer empirischen Theorie‘ haben sollte. Nur so wäre die größt mögliche Garantie gegeben, dass man sich mit Entwicklungsprozessen beschäftigt, die auf begründete Veränderungs-Regeln gründen. Zusätzlich gilt — das folgt aus der Evolution und aus dem Brundtland-Report — dass ‚Vielfalt (‚Diversity‘) von hoher Bedeutung ist; denn neben dem Wissen, das versucht sich im Rahmen einer empirischen Theorie abzusichern, gibt es auch die objektive ‚Begrenztheit‘ allen verfügbaren Wissens. Um nicht ‚Opfer der eigenen Begrenztheit‘ zu werden bedarf es daher eine ‚Vielfalt‘ an Menschen aus möglichst vielen Lebenssituationen, die Erfahrungen, Gedanken und Emotionen mit ins Spiel bringen, die vielleicht die ‚gewohnten Denkmuster‘ aufbrechen können.

Aus der Geschichte des menschlichen Lernens wissen wir, dass die älteste und erfolgreichste Form des Lernens das ‚Spielen‘ ist. Hier spielt Kreativität und spielen Emotionen neben dem Wissen immer eine wichtige Rolle.

Es ist von daher letztlich nicht überraschend, dass sich aufzeigen lässt, dass die Struktur einer empirischen Theorie — sogar in der erweiterten Form einer ’nachhaltigen empirischen Theorie‘ –sich Struktur-äquivalent zur Form des ‚Spielens‘ verhält.[19]

Im vorausgehenden Schaubild wird dies selbsterklärend verdeutlicht. Auf der Basis dieser Erkenntnis kann man daher im Alltag einer Kommune und auch im Alltag von Forschung und Lehre als Grundform das Format des ‚Spielens‘ wählen und es dazu benutzen, um in beliebig vielfältigen Formen gemeinsam ’nachhaltige empirische Theorien‘ zu all jenen Problemen zu entwickeln, die sich im Alltag für einer Kommune stellen.

AUSBLICK

Die zuvor geäußerten Gedanken werden aktuell sowohl im Rahmen der universitären Lehre angewendet wie auch im Rahmen von Experimenten mit neuen Formen der Bürgerbeteiligungen, die durchweg offen sind für eine direkte Kooperation mit den gewählten politischen Vertretern und der Verwaltung der Gemeinde.

Kritik und Anregungen zu diesen Gedanken sind willkommen: info@oksimo.org

ANMERKUNGEN

wkp := Wikipedia, de := Deutsch, en := Englisch

[1] Siehe ‚Universum‘ in wkp-de: https://de.wikipedia.org/wiki/Universum, Zitat: „Das Alter des Universums ist aufgrund von Präzisionsmessungen durch das Weltraumteleskop Plancksehr genau gemessen: 13,81 ± 0,04 Milliarden Jahre.“

[2] Volker Storch, Ulrich Welsch, Michael Wink, Evolutionsbiologie, 3.rev.Aufl., Springer Spektrum, Springer-Verlag, Berlin Heidelberg, 2013

[3] Peter Sitte, Symbiogenese in der Zell- und Lebensevolution, Exkurs 3.1. in [1], SS.234 – 245,

[3a] Zitat: „Es hat demnach schon vor mehr als 3,5 (vermutlich sogar 4) Mrd Jahren Leben auf unserem Planeten gegeben.“(S.234)

[3b] Wichtige Arbeitshypothese: Als wichtiger Motor der Evolution wird angenommen: stabile intertaxonomische Kombinationen, Mutation, Genetische Rekombination und horizontaler Gentransfer (vgl. [1],S.245)

[3c] Uwe Jürgens, Sprache, in: [2], SS.456-460.Jürgens grenzt die Entstehung von Sprache im modernen Sinn ein auf das Zeitfenster nach 2.6 Mio und 50.000 Jahen vor uns.

[4] Siehe ‚Leben‘ in wkp-de: https://de.wikipedia.org/wiki/Leben , Zitat: „Leben ist ein Sammelbegriff für eine Vielzahl materieller Erscheinungen (Systeme) in der Natur, die sich in einem ständigen, geregelten Austausch von Energie, Materie und Informationen befinden. Diese Prozesse werden je nach Betrachtungsweise als unterschiedliche reale oder zugeschriebene Eigenschaften beschrieben, die sich unverwechselbar von der unbelebten Umwelt unterscheiden. Über diese Eigenschaften und ihre Entstehung oder ihren Umfang – ob selbst erhaltend und organisierend oder von göttlichen Kräften geschaffen und gelenkt – besteht allerdings keine Einigkeit, weder innerhalb der Wissenschaften noch unter Philosophen oder in den Religionen. 1999 führte der israelische Chemiker Noam Lahav 48 verschiedene Definitionen von Experten der letzten 100 Jahre auf.“

[5] Siehe ‚Lebewesen‘ in wkp-de: https://de.wikipedia.org/wiki/Lebewesen , Zitat: „Lebewesen sind organisierte Einheiten, die unter anderem zu Stoffwechsel, Fortpflanzung, Reizbarkeit, Wachstum und Evolution fähig sind. Lebewesen prägen entscheidend das Bild der Erde und die Zusammensetzung der Erdatmosphäre (Biosphäre). Neuere Schätzungen lassen vermuten, dass 30 Prozent der gesamten Biomasse der Erde auf unterirdisch lebende Mikroorganismen entfallen. Rezente Lebewesen stammen immer von anderen Lebewesen ab (Abstammungstheorie). Über die Entstehung von Lebewesen aus abiogenen Vorformen wird intensiv geforscht. Zu den ältesten Spuren irdischer Lebewesen gehören insbesondere die Stromatolithen. Die Biologie untersucht die heute bekannten Lebewesen und ihre Evolution sowie die Grenzformen des Lebens (z. B. Viren) mit naturwissenschaftlichen Methoden.“

[6] Siehe ‚System‘ in wkp-de: https://de.wikipedia.org/wiki/System , Zitat: „Als System (altgriechisch sýstēma „aus mehreren Einzelteilen zusammengesetztes Ganzes“) wird etwas bezeichnet, das aus verschiedenen Komponenten mit unterschiedlichen Eigenschaften besteht, die aufgrund bestimmter geordneter Beziehungen untereinander als gemeinsames Ganzes betrachtet werden (können) und damit von anderem abgrenzbar sind.

Es gibt keine einheitliche Definition des Begriffs, da die Bedeutungszuweisung je nach Fachgebiet sehr unterschiedlich ist. Demnach ist auch der vorhergehende Satz eine Abstraktion im Sinne eines größten gemeinsamen Nenners. … In unterschiedlichen Fachgebieten werden spezifische Begriffsverwendungen vorgeschlagen, diskutiert und angewendet. Viele Systeme haben völlig andersartige Eigenschaften als die Komponenten, aus denen sie bestehen. Wenn sich diese neuen Qualitäten nicht allein aus dem funktionalen Zusammenwirken der Teile – „von unten“ betrachtet – erklären beziehungsweise vorausberechnen lassen, handelt es sich um emergente Eigenschaften. Sofern keine Beziehungen der genannten Art zwischen den Teilen eines Ganzen bestehen, handelt es sich nicht um ein System, sondern um bloße Mengen, Haufen oder Stoffgemische; auch wenn die konstruierte Anordnung der Teile einer bestimmten Systematik unterliegt und als „System“ bezeichnet wird (Beispiele: biologische Systematik, Periodensystem der Elemente).“

[7] Siehe ‚Evolution‘ in wkp-de: https://de.wikipedia.org/wiki/Evolution , Zitat „Unter Evolution (von lateinisch evolvere „herausrollen“, „auswickeln“, „entwickeln“) versteht man im deutschsprachigen Raum in erster Linie die biologische Evolution. Darunter wird die von Generation zu Generation stattfindende allmähliche Veränderung der vererbbaren Merkmale einer Population von Lebewesen und von anderen organischen Strukturen (z. B. Viren) verstanden. Das Lehr- und Forschungsgebiet der Evolution wird als Evolutionsbiologie bezeichnet und unterliegt, wie viele andere Wissenschaften, einem kontinuierlichen Erkenntnisfortschritt. Hierzu können insbesondere neue Einsichten durch die Entdeckung neuer Fossilien oder die Anwendung neuer Forschungsmethoden beitragen. Das Themenfeld der Evolution wurde zuweilen unterteilt in die Evolutionsgeschichte, in der die Veränderungen der Lebewesen im Laufe der Erdgeschichte beschrieben werden und bei dem es Überlappungen mit der Paläontologie gibt, sowie in die Evolutionstheorie, die naturwissenschaftliche Erklärungen (Hypothesen und Theorien) für das Gesamtphänomen der Evolution entwickelt. Die beiden Ansätze sind heutzutage in der Wissenschaft innig miteinander verwoben und befruchten sich wechselseitig. Wissenschaftler beschäftigen sich ebenfalls im Rahmen der theoretischen Biologie mit der biologischen Evolution. Die theoretische Biologie als interdisziplinäres Teilgebiet der Biologie entwickelt mathematische Modelle und führt statistische Hypothesentests und Laborexperimente durch, um den Erkenntnisgewinn zu fördern.“

[8] Siehe ‚Evolutionsbiologie‘ in wkp-de: https://de.wikipedia.org/wiki/Evolutionsbiologie , Zitat: „Die Evolutionsbiologie ist ein Teilbereich der Biowissenschaften. Sie untersucht das Evolutionsgeschehen im Laufe der Erdgeschichte bis heute sowie die Evolutionsfaktoren. Zentrale Problemstellungen moderner Evolutionsbiologie sind

- die Rekonstruktion der stammesgeschichtlichen Abläufe der Organismen,

- das Zusammenspiel der Evolutionsfaktoren untereinander und mit der Umwelt

- sowie die Evolution der Genomsysteme, die in enger Wechselbeziehung zu den jeweiligen Trägerorganismen stehen.

Die Evolutionsbiologie ist eng mit anderen Wissenschaftsdisziplinen verknüpft, z. B. Geologie, Paläontologie, Ökologie, Biogeographie, Anatomie/Morphologie, Physiologie, Biochemie, Verhaltensbiologie, Molekularbiologie und Genetik.“

[9] UN. Secretary-General;World Commission on Environment and Development, 1987, Report of the World Commission on Environment and Development : note / by the Secretary General., https://digitallibrary.un.org/record/139811 (accessed: July 20, 2022) (In einem besser lesbaren Format: https://sustainabledevelopment.un.org/content/documents/5987our-common-future.pdf) Anmerkung: Gro Harlem Brundtland (ehemalige Ministerpräsidentin von Norwegen) war die Koordinatorin von diesem Report. 1983 erhielt sie den Auftrag vom Generalsekretär der UN einen solchen Report zu erstellen, 1986 wurde er übergeben und 1987 veröffentlicht. Dieser Text enthält die grundlegenden Ideen für alle weiteren UN-Texte.

Zitat aus dem Vorwort: „The fact that we all became wiser, learnt to look across cultural and historical barriers, was essential. There were moments of deep concern and potential crisis, moments of gratitude and achievement, moments of success in building a common analysis and perspective. The result is clearly more global, more realistic, more forward looking than any one of us alone could have created. We joined the Commission with different views and perspectives, different values and beliefs, and very different experiences and insights. After these three years of working together, travelling, listening, and discussing, we present a unanimous report.“ und „Unless we are able to translate our words into a language that can reach the minds and hearts of people young and old, we shall not be able to undertake the extensive social changes needed to correct the course of development.“

Zitat aus dem Abschnitt ‚Sustainable Development‘:

„27. Humanity has the ability to make development sustainable to ensure that it meets the needs of the present without compromising the ability of future generations to meet their own needs. The concept of sustainable development does imply limits – not absolute limits but limitations imposed by the present state of technology and social organization on environmental resources and by the ability of the biosphere to absorb the effects of human activities. But technology and social organization can be both managed and improved to make

way for a new era of economic growth. The Commission believes that widespread poverty is no longer inevitable. Poverty is not only an evil in itself, but sustainable development requires meeting the basic needs of all and extending to all the opportunity to fulfil their aspirations for a better life. …

28. Meeting essential needs requires not only a new era of economic growth for nations in which the majority are poor, but an assurance that those poor get their fair share of the resources required to sustain that growth. Such equity would be aided by political systems that secure effective citizen participation in decision making and by greater democracy in international decision making.

29. Sustainable global development requires that those who are more affluent adopt life-styles within the planet’s ecological means – in their use of energy, for example. Further, rapidly growing populations can increase the pressure on resources and slow any rise in living standards; thus sustainable development can only be pursued if population size and growth are in harmony with the changing productive potential of the ecosystem.

30. Yet in the end, sustainable development is not a fixed state of harmony, but rather a process of change in which the exploitation of resources, the direction of investments, the orientation of technological development, and institutional change are made consistent with future as well as present needs. We do not pretend that the process is easy or straightforward. Painful choices have to be made. Thus, in the final analysis, sustainable development must rest on political will.“

[10] Die 17 Entwicklungsziele der Vereinigten Nationen (2015): https://sdgs.un.org/goals, Zitat: „The 2030 Agenda for Sustainable Development, adopted by all United Nations Member States in 2015, provides a shared blueprint for peace and prosperity for people and the planet, now and into the future. At its heart are the 17 Sustainable Development Goals (SDGs), which are an urgent call for action by all countries – developed and developing – in a global partnership. They recognize that ending poverty and other deprivations must go hand-in-hand with strategies that improve health and education, reduce inequality, and spur economic growth – all while tackling climate change and working to preserve our oceans and forests.

The SDGs build on decades of work by countries and the UN, including the UN Department of Economic and Social Affairs“

[11] UN, Transforming our world: the 2030 Agenda for

Sustainable Development: https://sdgs.un.org/2030agenda, Zitat: „This Agenda is a plan of action for people, planet and prosperity. It also seeks to strengthen universal peace in larger freedom. We recognise that eradicating poverty in all its forms and dimensions, including extreme poverty, is the greatest global challenge and an indispensable requirement for sustainable development. All countries and all stakeholders, acting in collaborative partnership, will implement this plan. We are resolved to free the human race from the tyranny of poverty and want and to heal and secure our planet. We are determined to take the bold and transformative steps which are urgently needed to shift the world onto a sustainable and resilient path. As we embark on this collective journey, we pledge that no one will be left behind. The 17 Sustainable Development Goals and 169 targets which we are announcing today demonstrate the scale and ambition of this new universal Agenda. They seek to build on the Millennium Development Goals and complete what these did not achieve. They seek to realize the human rights of all and to achieve gender equality and the empowerment of all women and girls. They are integrated and indivisible and balance the three dimensions of sustainable development: the economic, social and environmental.“ (Zuletzt: 8.April 2023)

[12] UN, Transforming our world: the 2030 Agenda for

Sustainable Development, https://documents-dds-ny.un.org/doc/UNDOC/GEN/N15/291/89/PDF/N1529189.pdf?OpenElement (Zuletzt: 8.April 2023)

[13] Hessische Gemeindeverordnung (HGO), siehe: https://www.rv.hessenrecht.hessen.de/bshe/document/jlr-GemOHE2005V9IVZ (zuletzt: 11.April 2023)

[14] Gemeinde 61137 Schöneck: Hauptsatzung von 2021: https://www.schoeneck.de/rathaus-politik/aktuelles/amtliche-bekanntmachungen/2021/hauptsatzung-der-gemeinde-schoeneck/

[15] Gemeinde 61137 Schöneck, Gemeindevertretung – Geschäftsordnung (GO): https://www.schoeneck.de/rathaus-politik/service/satzungen/geschaeftsordnung-fuer-die-gemeindevertretung-und-die-ausschuesse.pdf?cid=321

[16] Gerd Doeben-Henisch, Dez.2022, NACHHALTIGE EMPIRISCHE THEORIE – VERSCHIEDENE FORMATE: THEORIE – SPIEL – THEATERSTÜCK, https://www.oksimo.org/2022/12/14/nachhaltige-empirische-theorie-verschiedene-formate/

[17] Siehe ‚Phänotyp‘ in wkp-de: https://de.wikipedia.org/wiki/Ph%C3%A4notyp , Zitat: „Der Phänotyp (von altgriechisch φαίνω phaíno „ich erscheine“ und τύπος týpos „Gestalt“) oder das Erscheinungsbild ist in der Genetik die Menge aller Merkmale eines Organismus. Er bezieht sich nicht nur auf morphologische, sondern auch auf physiologische Eigenschaften und ggfs. auf Verhaltensmerkmale. In der Vererbungslehre wurde der Begriff Phaenotypus erstmals von Wilhelm L. Johannsen aufgestellt. Phänotypen und phänotypische Variationen werden durch das Zusammenwirken von Erbanlagen und Umweltfaktoren (Modifikation) bestimmt. Inwieweit der Phänotyp durch Umwelteinflüsse beeinflussbar ist, hängt von der Reaktionsnorm ab. Diese Möglichkeit, auf Umwelteinflüsse zu reagieren, ist durch den Genotyp genetisch festgelegt. Verfahren, mit denen Rückschlüsse vom Erbgut, d. h. der individuellen Desoxyribonukleinsäure (DNS), auf den Phänotyp eines Individuums geschlossen werden, werden DNA-Phänotypisierung genannt.“

[18] Siehe ‚Biologie‘ in wkp-de: https://de.wikipedia.org/wiki/Biologie , Zitat: „Biologie (von altgriechisch βίος bíos „Leben“ und λόγος lógos hier: „Lehre“, siehe auch -logie) oder historisch auch Lebenskunde ist die Wissenschaft von der belebten Materie, den Lebewesen. Sie ist ein Teilgebiet der Naturwissenschaften und befasst sich sowohl mit den allgemeinen Gesetzmäßigkeiten des Lebendigen als auch mit den Besonderheiten der einzelnen Lebewesen: zum Beispiel mit ihrer Entwicklung, ihrem Bauplan und den physikalischen und biochemischen Vorgängen in ihrem Inneren. Im Fach Biologie wird in zahlreichen Teilgebieten geforscht. Zu den ganz allgemein auf das Verständnis des Lebendigen ausgerichteten Teilgebieten gehören insbesondere Biophysik, Genetik, Molekularbiologie, Ökologie, Physiologie, Theoretische Biologie und Zellbiologie. Mit großen Gruppen der Lebewesen befassen sich die Botanik (Pflanzen), die Zoologie (Tiere) und die Mikrobiologie (Kleinstlebewesen und Viren). Die Betrachtungsobjekte der Biologie umfassen u. a. Moleküle, Organellen, Zellen und Zellverbände, Gewebe und Organe, aber auch das Verhalten einzelner Organismen sowie deren Zusammenspiel mit anderen Organismen in ihrer Umwelt. Diese Vielfalt an Betrachtungsobjekten hat zur Folge, dass im Fach Biologie eine Vielfalt an Methoden, Theorien und Modellen angewandt und gelehrt wird. Die Ausbildung von Biologen erfolgt an Universitäten im Rahmen eines Biologiestudiums, von Biologie-Lehramtsstudierenden zumindest zeitweise auch im Rahmen der Biologiedidaktik.In neuerer Zeit haben sich infolge der fließenden Übergänge in andere Wissenschaftsbereiche (z. B. Medizin, Psychologie und Ernährungswissenschaften) sowie wegen des interdisziplinären Charakters der Forschung neben der Bezeichnung Biologie weitere Bezeichnungen für die biologischen Forschungsrichtungen und Ausbildungsgänge etabliert wie zum Beispiel Biowissenschaften, Life Sciences und Lebenswissenschaften.“

[19] Anmerkung: Den Begriff ‚Empirische Theorie‘ gibt es weder in der wkp-de noch in der wkp-en! Da der Begriff der ‚empirischen Theorie‘ der harte Kern des modernen Wissenschaftsbegriffs ist (eng verbunden mit moderner Logik und Mathematik) kann man sich fragen, was es heißt, dass über ‚Wissenschaft‘ geredet wird, ohne dass man den Begriff ‚empirische Theorie‘ benutzt (und dies gilt nahezu für die gesamte Wissenschaftswelt, nicht nur für die Welt-Enzyklopädie Wikipedia).